【Google Cloud Next Tokyo 2025】Day2 基調講演 :講演レポート

Google Cloud Next Tokyo 2025とは?

Google Cloud Next は、Google Cloud が主催する大規模なオンサイトイベントです。2025年8月5(火)と6日(水)の2日間、東京ビッグサイトで開催され、オンラインでのライブ配信も行われます。

本イベントでは、最新のクラウド技術や生成 AI ソリューションが紹介され、業界リーダーによるセッション、革新的なデモ、ネットワーキングの機会を通じて、Google Cloud が実現する未来を体験可能です。

セッション情報

| セッション名 | Day2 基調講演 |

|---|---|

| セッション概要 | Day 2 の基調講演では、AI エージェントを活用・構築する上で不可欠な、データ、アプリ、インフラ、そしてセキュリティの核心に迫ります。Google Cloud の最新情報と、それがもたらす具体的な効果とは?金融や小売業界をはじめ、各業界をリードする企業が、他では聞けない成功事例と実践ノウハウを特別に公開します。デモでは実際の利用イメージを、ぜひご自身の目で確かめてください。みなさまの次の一手につながる洞察をお届けします。 |

| 登壇者 | 渕野大輔氏 ブラッド カルダー氏 平位 文淳氏 丹羽 大介氏 山本 忠司氏 アンディ ガットマンズ氏 西村 出氏 北迫 清訓氏 塚越 啓介氏 安藤 梨花氏 桐谷 彰一氏 |

AIエージェントが拓く、インフラと開発の未来

Google Cloud Next Tokyo Day 2では、AI時代の本格的な到来を告げる数多くの発表が行われました。本講演の核となるメッセージは、AIエージェントがインフラ運用、アプリケーション開発、データ活用、そしてセキュリティのあらゆる領域に深く浸透し、これまでの常識を覆す自律的な世界の実現です。

本記事では、この基調講演で明らかにされた、インフラエンジニアやSREにとって見逃せない主要なアップデートを、講演の時系列に沿って解説します。

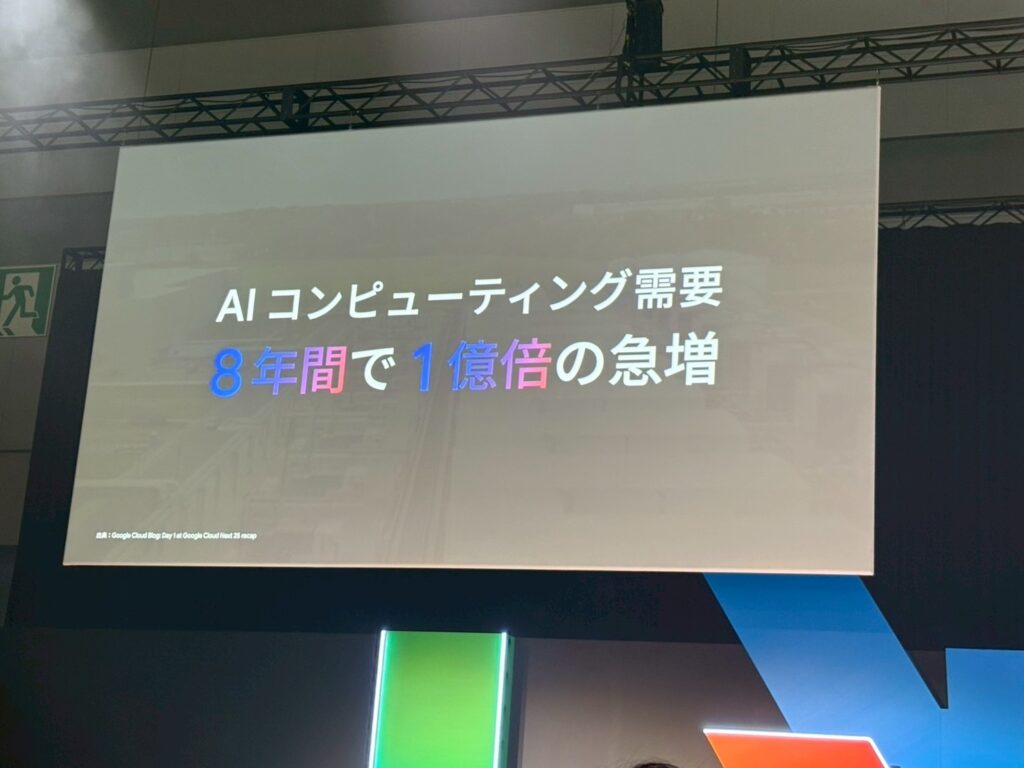

AI時代の到来:1億倍に急増したコンピューティング需要への挑戦

講演の冒頭、AIコンピューティングの需要が過去8年間で1億倍に急増したという衝撃的な事実が示されました。この爆発的な需要に応えるため、Google Cloudはハードウェアのイノベーションから、統合されたソフトウェア、そしてサービスプラットフォームに至るまで、全てのレイヤーでエンドツーエンドのサービスを提供しています。

この一気通貫したアプローチこそが、企業のAI活用を強力に支援するGoogle Cloudの最大の強みであると強調されました。

AIワークロードを支える、次世代AIインフラストラクチャーの全貌

AIの導入を簡素化し、パフォーマンスを最大化するために設計された、まさに「AI時代のスーパーコンピューティングシステム」として、Google CloudのAIインフラが紹介されました。

ハードウェアの進化は特に目覚ましく、AI専用チップの第7世代となるTPU「Ironwood」が発表されました。これは前世代比で10倍以上の性能向上と29倍のエネルギー効率改善を両立しており、Geminiのような巨大で要求の厳しいモデルの実行を可能にします。

また、NVIDIAの最新GPUであるGB200やB200を搭載したVMをいち早く市場投入し、将来的には次世代のRubin/VeraGPUも先行して提供する予定です。

これらの強力なハードウェアを効率的に活用するため、管理・ストレージ、そしてソフトウェアの各レイヤーでも重要な機能強化が発表されました。

| カテゴリ | 機能名 | 概要 |

|---|---|---|

| 管理 | Cluster Director | 数千、数万のアクセラレーターを単一のコンピューティングユニットとして効率的に管理します。 |

| ストレージ | Hyperdisk Exapools | AIクラスターに最高のパフォーマンスと大容量を提供するブロックストレージです。 |

| ストレージ | Cloud Storage Anywhere Cache | データをAIアクセラレーターの近くに保持し、IOレイテンシを最大70%改善します。 |

| ソフトウェア | vLLM on TPU | GPU向けに最適化されたvLLMを、TPU上でより簡単かつ費用対効果高く実行可能にします。 |

| ソフトウェア | GKE Inference Gateway | 推論ワークロードのルーティングや負荷分散を最適化し、効率化を実現します。 |

IT運用担当者なら押さえておきたい、「TPU Ironwood」と「Cluster Director」

これらの発表の中で特に運用担当者にとって重要なのは、「TPU Ironwood」と「Cluster Director」でしょう。

TPU Ironwoodは、一言で言うとAIの計算を爆速かつ省エネルギーで実行する専用心臓部です。大規模AIの活用における経済的なハードルを下げ、より多くの企業がAI開発に取り組むことを可能にします。一方、Cluster Directorは、多数の計算機リソースを一台のコンピューターのように扱えるようにする指揮官の役割を果たします。これにより、大規模なAI基盤の運用が劇的に簡素化され、管理負担が大幅に軽減されます。

日本国内でも、トヨタ自動車が製造工程の工数削減に、ソニー・ホンダモビリティがADASの基盤モデル開発に、そして東京科学大学が日本語LLMの研究にGoogle CloudのAIインフラを活用している事例が紹介されました。

GKEとCloud Runの進化:AI時代のアプリケーション実行基盤

発表から10周年を迎えたGoogle Kubernetes Engine (GKE)は、AIワークロードの実行基盤として大きな進化を遂げています。コンテナに最適化されたコンピューティングを提供するGKE Autopilotはパフォーマンスが7倍向上し、さらにGKE StandardクラスタでもAutopilotモードが利用可能になりました。また、推論ワークロードを効率化するGKE Inference Gatewayや、モデルのデプロイを容易にするInference Quick Startといった新機能も追加されています。

サーバーレスプラットフォームであるCloud Runも、GPUの一般提供(GA)を開始しました。これにより、リアルタイム推論や画像生成といったユースケースにおいて、オンデマンドでGPUリソースをスケール・トゥ・ゼロや秒単位の課金で利用できます。

スポーツ界と金融界における、画期的な導入事例

このセッションでは、スポーツ界と金融界における画期的な導入事例が紹介されました。 NPBエンタープライズとソニーは、映像判定システム「ホークアイ」から得られる膨大な試合データをGoogle Cloud上で処理しています。GKE AutopilotとCloud GPUを活用して全試合・全プレーのCGコンテンツを自動生成し、これまでにない野球の楽しみ方を提供しています。採用の決め手は、高いコストパフォーマンスとAPIによるアクセスの容易性でした。

また、三菱UFJフィナンシャル・グループは、2026年度中の開業を目指す新デジタルバンク「エムット」の勘定系システムにCloud Spannerの導入を決定しました。リージョンレベルの障害が発生してもサービスが停止せず、データの整合性が保証されるという、ミッションクリティカルな金融システムに不可欠な要件を満たす点が決め手となったと語られました。

開発者の新たな相棒、Geminiがもたらす自律的な開発スタイル

開発者の生産性を飛躍的に向上させるAIとして、Geminiの進化が紹介されました。すでにGoogle社内では、コードの30%以上がAIによって生成されているとのことです。

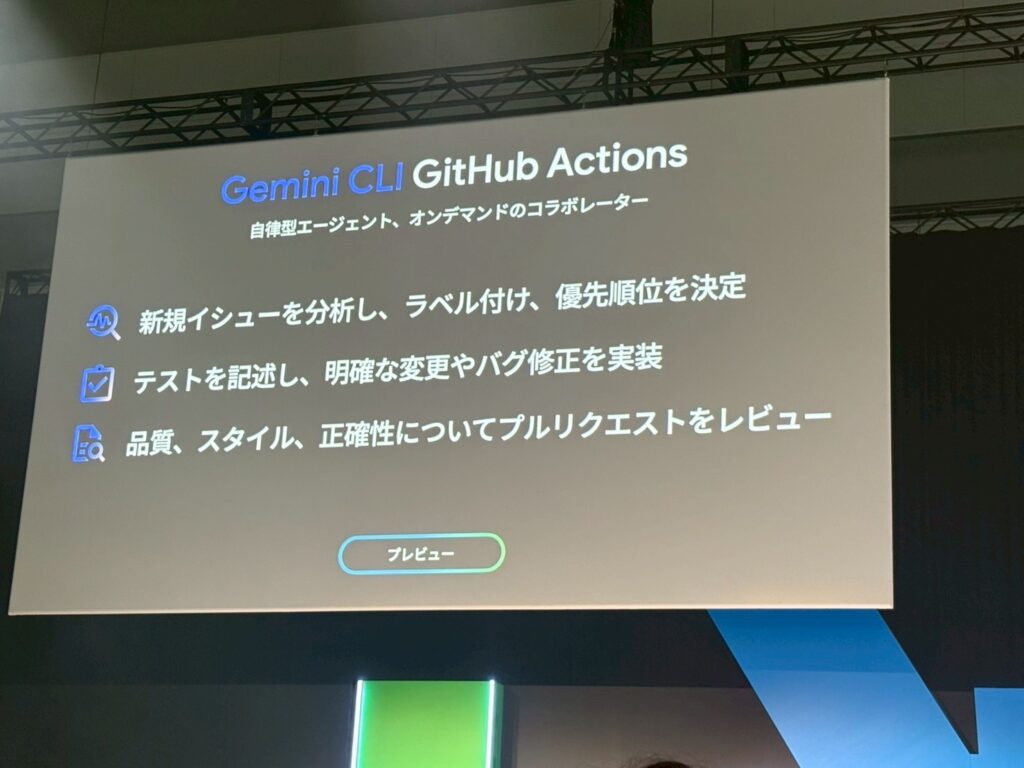

新発表、「Gemini CLI GitHub Actions」

特に注目すべきは、新たに発表された「Gemini CLI GitHub Actions」です。これは、GitHubリポジトリのための自律的なAIコーディングチームメイトとして機能します。Issueの分析やラベル付け、プルリクエストのレビュー、さらにはテストの実装やバグ修正までを自律的に行うことができ、まさに「オンデマンドのコラボレーター」と呼べる存在です。

デモンストレーションでは、Gemini CLIがいかに開発・運用作業を効率化するかが示されました。プロジェクトの全体像の把握、Linuxコマンドの自動生成、アプリケーションのローカル起動、さらにはGitHub上のIssueと画像ファイルをもとにしたコード修正まで、一連の作業を自然言語の指示だけで実行していく様子は、新しい開発スタイルの到来を強く印象付けました。

AIネイティブなデータ基盤へ:BigQueryとSpannerが機能強化

データとAIによってビジネスプロセスが再構築される現代において、Googleは「AIネイティブなデータクラウド」というビジョンを掲げました。これは、サイロ化されたツールの集合体ではなく、単一の統合されたプラットフォームとして機能します。

その中核を担うプラットフォームにおいて、画期的な機能強化が発表されました。 BigQueryでは、データに対して自動でエンベディングを生成し、インデックスを作成する機能が搭載されました。これにより、ベクトル検索の準備が大幅に簡素化されます。さらに、SQLクエリ内で顧客の感情分析などを行える新しいAIクエリエンジンも導入されました。 AlloyDBとSpannerにはカラム型エンジンが導入され、トランザクションデータを扱いながら、同時に高速な分析が可能になります。特にSpannerでは、分析性能が最大で200倍も向上するとのことです。

これらの新機能の中で特に注目すべきは、「BigQueryの自律的エンベディング生成」と「Spannerのカラム型エンジン」です。 前者は、一言で言えばデータを入れるだけでAIが検索しやすいように自動で整理してくれる機能です。これまで専門知識が必要だったベクトル検索の導入が容易になり、運用担当者は複雑な作業から解放されます。 後者は、取引処理(OLTP)とデータ分析(OLAP)という、従来は別のデータベースで行うのが常識だった処理を一つで実現する仕組みです。これによりシステム構成がシンプルになり、よりリアルタイム性の高い分析が可能になります。

オープン性も重視されており、データレイクの標準としてApache Icebergが採用され、BigLakeを通じて様々なエンジンから統一的に管理・利用できるようになります。また、Apache Sparkを4倍高速化する「Lightning Engine」や、Oracle Database at Google Cloudの東京リージョン開設と2026年初頭の大阪リージョン展開計画も発表されました。

セブン&アイ・ホールディングスの導入事例

セブン&アイ・ホールディングスの事例では、BigQueryを中核としたリアルタイムデータ基盤「セブンセントラル」が紹介されました。1日52億件ものレコードを処理し、次世代の店舗システムではSpannerやAlloyDBも活用することで、信頼性と柔軟性の高いデータ基盤を構築し、「真のデータの民主化」を目指していると語られました。

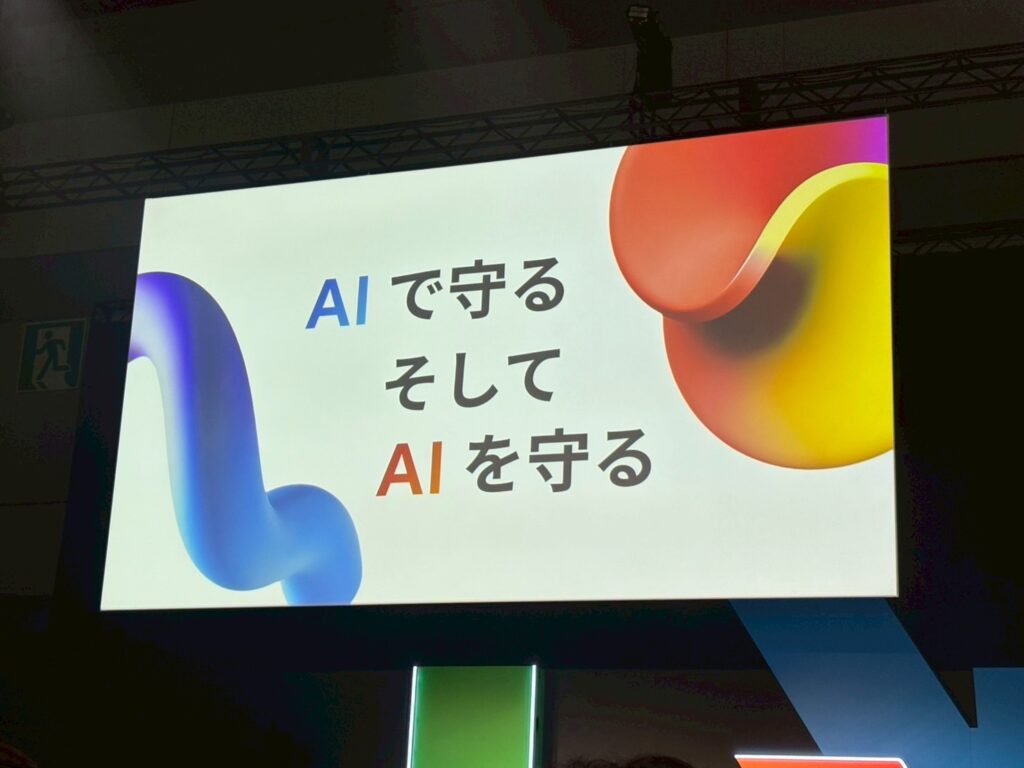

AIで防御し、AI資産を保護する:新時代のセキュリティ戦略

最後に、巧妙化するサイバー攻撃に対抗するための、AIを活用した新しいセキュリティアプローチが示されました。 「AIで守る」アプローチとして、Google Security Operationsにセキュリティエージェントが搭載されます。

このエージェント同士が連携し、アラートの分析から対応までを自律的に行うことで、セキュリティ運用を自動化します。 同時に、「AIを守る」アプローチとして、モデルの盗難やデータ汚染、プロンプトインジェクションといったAI特有の脅威から資産を保護する「AI Protection」機能も発表されました。

最初の一歩を踏み出そう

今回の基調講演では、AIエージェントがインフラから開発、データ、セキュリティに至るまで、あらゆる領域で自律的に機能し、人間の作業を高度化・自動化していく未来像が具体的に示されました。これは、単なる効率化ではなく、ビジネスのあり方そのものを変革する大きな可能性を秘めています。

紹介された数多くの新機能やサービスを前に、どこから手をつければよいか迷うかもしれません。しかし、重要なのは最初の一歩を踏み出すことです。例えば、まずはGemini CLIを導入し、日々の定型的なコマンドライン作業を自然言語で実行してみることから始めてみてはいかがでしょうか。あるいは、BigQueryに蓄積された既存のデータを、新しいAIクエリエンジンを使って分析し、これまで見えなかったインサイトを探してみるのも良いでしょう。

今回の発表の中から、まずは一つでもご自身の業務に関連する機能を試してみることをお勧めします。その一歩が、AI時代の新しい働き方への扉を開く鍵となるはずです。